La compañía informó que está trabajando con la Agencia de Proyectos de Investigación Avanzados de Defensa de Estados Unidos

Diseñará nuevas herramientas de ciberseguridad, y mejorar la protección del software que da soporte a la infraestructura de seguridad del país

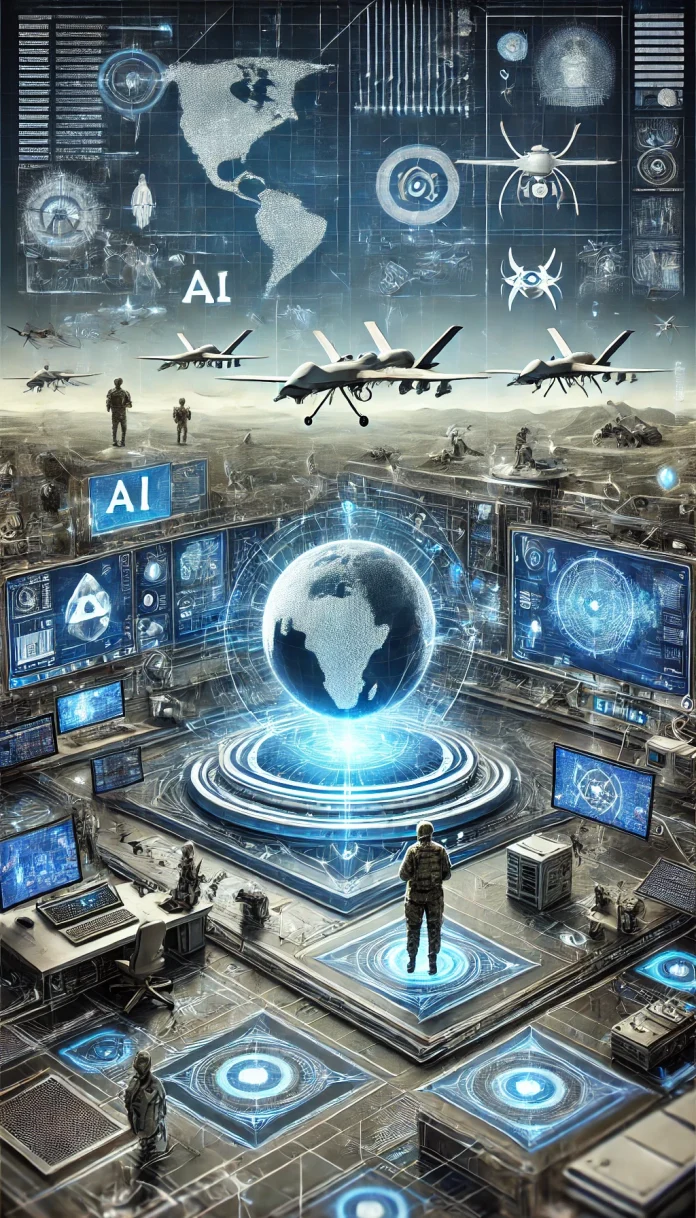

OpenAI ha decidido cruzar un umbral que hasta hace poco permanecía cerrado: el uso de su inteligencia artificial (IA) en aplicaciones militares. Este giro en su política, anunciado el pasado 10 de enero, permite la colaboración con agencias de seguridad nacional, pero con un límite claro: solo en contextos defensivos. La medida ha generado un debate polarizado, con algunos elogiando su potencial para fortalecer la seguridad y otros cuestionando las implicaciones éticas de esta decisión.

OpenAI ha justificado esta medida al señalar que la IA puede desempeñar un papel crucial en la protección de vidas humanas frente a amenazas globales. La compañía asegura que su tecnología no se usará en armas ofensivas, sino en iniciativas como la ciberseguridad y la defensa contra drones autónomos. Un ejemplo notable de este cambio es su asociación con Anduril, una firma de tecnología de defensa conocida por sus sistemas de vigilancia y drones. Gracias a los modelos de OpenAI, esperan optimizar el análisis de datos en tiempo real, mejorando la capacidad de respuesta.

El giro también tiene una dimensión económica. En un contexto donde el gasto militar global alcanzó los 2.24 billones de dólares en 2022, según datos del Instituto Internacional de Investigaciones para la Paz de Estocolmo (SIPRI), entrar en este mercado representa una oportunidad lucrativa. Estados Unidos, que lidera el gasto con 877,000 millones de dólares, es un cliente potencial clave. OpenAI, que enfrenta pérdidas proyectadas de 5,000 millones de dólares para 2024, podría encontrar en este sector una vía para aliviar su tensión financiera. Sin embargo, este movimiento también abre un nuevo frente de críticas éticas.

El empleo de IA en contextos militares no está exento de controversias. Organismos internacionales han advertido sobre los peligros de crear armas autónomas letales, ataques cibernéticos automatizados o la manipulación de datos críticos. Aunque OpenAI afirma que evitará estas áreas, los detractores señalan que la tecnología podría ser utilizada indirectamente con fines cuestionables. Además, los modelos generativos de OpenAI, como GPT-4, ya han demostrado sesgos y problemas de precisión que podrían tener consecuencias fatales si no se controlan adecuadamente.

La decisión de OpenAI se da en un contexto de creciente regulación. En octubre de 2024, 31 países firmaron un compromiso no vinculante para garantizar que la IA militar respete las leyes internacionales y los derechos humanos. Aunque la eficacia de este acuerdo está por verse, refleja la preocupación global por las implicaciones de la militarización de la IA. OpenAI ha expresado su apoyo a estos principios y asegura que su colaboración estará guiada por valores democráticos.

Con esta decisión, OpenAI está explorando un terreno resbaladizo donde la línea entre defensa y ofensiva puede volverse difusa. Si bien la compañía promete actuar de manera responsable, las preocupaciones éticas y los riesgos de abuso son ineludibles. En un mundo cada vez más interconectado y vulnerable, la entrada de OpenAI en el sector militar podría redefinir tanto su futuro como el de los conflictos armados mediadores por tecnología.

La nueva política entró en vigor el pasado 10 enero. Antes de esta fecha, las normas de OpenAI calificaban la utilización de sistemas como ChatGPT y GPT-4 en la industria militar y bélica como una actividad de “alto riesgo físico”. La empresa dirigida por Sam Altman aclara que “existen casos de uso de seguridad nacional que se alinean con nuestra misión”.

OpenAI intenta explorar nuevas oportunidades de negocio alrededor de una industria millonaria. El gasto militar se elevó a 3.7% en 2022 para alcanzar los 2.24 billones de dólares. La cifra es equivalente al 2.2% del Producto Interno Bruto global, de acuerdo con estimaciones del Instituto Internacional de Investigaciones para la Paz de Estocolmo (SIPRI, por sus siglas en inglés). Estados Unidos es la nación que más recursos invierte en temas de defensa con un gasto calculado en 877,000 millones de dólares, tres veces más que la cantidad registrada en China, el segundo país que más dinero destina a tareas militares.

Ahora, OpenAI está abrazando abiertamente su trabajo en materia de seguridad nacional. Si trabajar con ejércitos o empresas de tecnología de defensa puede ayudar a garantizar que los países democráticos dominen la carrera de la IA, ha escrito la empresa, hacerlo no contradirá la misión de OpenAI de garantizar que los beneficios de la IA se compartan ampliamente. De hecho, sostiene, ayudará a cumplir esa misión.

Amazon, Google y Microsoft, socio e inversor de OpenAI, han competido por los contratos de computación en la nube del Pentágono durante años. Esas empresas han aprendido que trabajar con defensa puede ser increíblemente lucrativo, y el cambio de rumbo de OpenAI, que se produce en un momento en que la empresa espera pérdidas de 5.000 millones de dólares y, según se informa, está explorando nuevas fuentes de ingresos como la publicidad, podría indicar que quiere una parte de esos contratos. Las relaciones de las grandes tecnológicas con el ejército tampoco suscitan ya la indignación y el escrutinio que antes. Pero OpenAI no es un proveedor de la nube, y la tecnología que está construyendo puede hacer mucho más que simplemente almacenar y recuperar datos. Con esta nueva asociación, OpenAI promete ayudar a clasificar los datos en el campo de batalla, proporcionar información sobre las amenazas y ayudar a que el proceso de toma de decisiones en la guerra sea más rápido y eficiente.

La organización aún prohíbe el uso de sus algoritmos de IA para desarrollar armas, vigilar comunicaciones, destruir propiedad y crear cualquier clase de herramienta que produzca algún daño. Niko Feliz, vocero de OpenAI, explicó que el objetivo de la actualización de las políticas es “crear un conjunto de principios universales que sean fáciles de recordar y aplicar, especialmente porque nuestras herramientas ahora son utilizadas globalmente por usuarios cotidianos que ahora también pueden construir sistemas GPT personalizados”.